Článek jsem několikrát přepisoval. Hrozba umělé superinteligence se mi nyní zdá velmi vážná. Jak to ale napsat tak, abych nepůsobil příliš alarmisticky, depresivně? Jak zachovat naději? Jak vzbudit zájem o dané téma, namísto vyvolání existenciální krize?

Na základě níže uvedených zdrojů jsem po téměř dvou letech studia dospěl k závěru, že existuje vysoká pravděpodobnost, že v horizontu 2 až 15 let by mohla umělá superinteligence způsobit katastrofu pro celé lidstvo, v krajním případě i jeho úplné vyhlazení.

Mé současné předpoklady a predikce o budoucnosti vývoje umělé inteligence (AI):

- Lidská inteligence zdaleka nepředstavuje vrchol inteligence.

- Existují silné tlaky na vývoj stále výkonnějších AI modelů, což vede k růstu jejich inteligence.

- V blízké budoucnosti AI modely překonají lidskou inteligenci a budou se dále zlepšovat, což povede k umělé superinteligenci.

- Umělou superinteligenci nelze z dlouhodobého hlediska udržet pod kontrolou.

- Lidstvo bude v nedaleké budoucnosti nahrazeno či vyhlazeno umělou superinteligencí.

Umělá superinteligence: Co to vlastně je?

Umělá všeobecná superinteligence (artificial general superintelligence – ASI), je pro účely tohoto článku definována jako nebiologická, lidmi vytvořená inteligence, která dokáže vykonávat veškeré činnosti na vyšší úrovni než celé lidstvo. Z této definice mimo jiné plyne, že ASI by mohla být schopna vytvářet ještě inteligentnější umělé inteligence a tím se neustále vylepšovat. Mohla by provádět vědecký výzkum mnohonásobně rychleji a efektivněji než nejinteligentnější lidé. Její inteligence by mohla v průběhu času dále růst, dokud by nenarazila na fundamentální fyzikální limity. V takovém okamžiku si již ani nedokážeme představit, co by taková superinteligentní entita dělala, neboť by to bylo daleko za hranicemi našeho chápání. Bylo by to jako se snažit vysvětlit mravenci, jak funguje jaderná elektrárna.

Je možné vytvořit umělou superinteligenci? A pokud ano, za jak dlouho?

V současné době neexistují důkazy o žádných fyzikálních či jiných limitech, které by bránily vytvoření ASI. V posledních letech se vývoj AI značně zrychlil, přičemž nejvýkonnější modely jako OpenAI o1 nebo Claude 3.5 vykazují schopnosti, které překvapily nejednoho odborníka na umělou inteligenci. Pokud tento trend bude pokračovat, můžeme se k vytvoření ASI přiblížit již v tomto desetiletí. Může to trvat déle, pokud současné architektury neuronových sítí narazí na své limity a bude třeba hledat nové přístupy.

Velmi rychle může vzniknout zpětná vazba, kdy AI již nyní přispívá k vývoji lepších čipů, výkonnějších AI modelů, nových přístupů a algoritmů. Čím jsou tyto modely inteligentnější, tím užitečnější se stávají při vytváření nejen další generace AI, ale i hardwaru na kterém běží, jako např. kvantové počítače. Tento proces může pokračovat a dále exponenciálně urychlovat technologický pokrok.

“Úspěch při vytváření účinné umělé inteligence (AI) by mohl být největší událostí v dějinách naší civilizace. Nebo tou nejhorší. To prostě nevíme. Nemůžeme tedy vědět, zda nám AI nekonečně pomůže, nebo nás bude ignorovat a postaví nás na vedlejší kolej, nebo nás případně zničí… Pokud se nenaučíme, jak se na potenciální rizika připravit a vyhnout se jim, může být AI tou nejhorší událostí v dějinách naší civilizace.” – Stephen Hawking

Problém sladění (zarovnání) umělé superinteligence

Umělá superinteligence by mohla mít potenciál zničit lidstvo. Je důležité si uvědomit, že v tom nemusíme hledat zlé úmysly – podobně jako člověk, který při stavbě dálnice neúmyslně zabije mnoho hmyzích jedinců. My lidé, i celá planeta Země, jsme složeni z atomů a ASI by je mohla dříve či později potřebovat k jiným účelům, které by nebyly kompatibilní s naším přežitím. Tento problém sladění (alignment problem – problém sladění hodnot a záměrů umělé inteligence s lidskými) zůstává nevyřešen navzdory dlouhodobému výzkumu v oblasti AI, a zatím neexistují důkazy o tom, že by vůbec řešitelný byl. Jinými slovy, zabývá se tím, jak dlouhodobě přimět superinteligentní entity (jejichž inteligence v čase roste), aby dělaly přesně to, co chtějí lidé – jejich méně inteligentní stvořitelé. Není to otázka jen příštího AI modelu, ale všech modelů, které kdy v budoucnosti vzniknou, každý výkonnější než ten předchozí. Myslíte si, že je to možné?

“Nejde o to být optimistou nebo pesimistou. Jde o skutečný stav věcí? Mám pravdu? Pokud v mé logice vidíte chybu, publikujte ji, dokažte mi, že se mýlím. Přesvědčte mě, že máte funkční mechanismus pro kontrolu umělé superinteligence, která bude neomezeně škálovatelná. Nemluvím o řešení problému v jediném okamžiku. Nejde jen o kontrolu GPT-7, ale o dlouhodobý a trvalý bezpečnostní problém, který se týká všech budoucích modelů – GPT-205, superinteligence vytvořené další superinteligencí, která se bude škálovat do nekonečna. Pokud věříte, že to zvládnete bez jediné chyby, pak můžeme být optimističtí.” – Roman Yampolskiy

V další části článku bych rád poukázal na faktory současného světa a oblasti umělé inteligence, které nás směřují k nesladěné ASI, a to možná již za 2, 10 nebo 15 let – v průběhu našich životů (je možné, že to bude trvat déle, ale na výsledku to nic nemění):

- Neproniknutelnost současných AI systémů: Nejvýkonnější modely umělé inteligence, jako je GPT-4 (velký jazykový model založený na architektuře transformátorů), jsou nesmírně komplexní, což způsobuje, že nikdo, ani jejich tvůrci, nevědí, jak uvnitř přesně fungují. Jsou to „černé skříňky”. Tato neprůhlednost představuje významné riziko, neboť není možné přesně předvídat nebo kontrolovat chování takových AI systémů. V důsledku toho nemůžeme s jistotou říci, zda nám AI nelže nebo zda její rozhodnutí nebudou mít nechtěné důsledky. Tento bod mě nejvíce překvapil.

- Rychlý vývoj AI oproti výzkumu sladění: V posledních letech jsme svědky rychlého pokroku v oblasti AI, který významně předbíhá naše pochopení a schopnost řešit problémy spojené se sladěním. Tento nesoulad mezi výkonem AI systémů a naším pokrokem v řešení problému sladění zvyšuje riziko vzniku nesladěné ASI.

- AI bylo vypuštěno veřejnosti: Nástroje umělé inteligence se ve velké míře otevřely veřejnosti (30. listopadu 2022 byl vypuštěn ChatGPT), což způsobuje, že vývoj AI se stává atraktivním a lukrativním pro mnoho společností. Finanční motivace spojená s vývojem stále výkonnějších a sofistikovanějších AI systémů neustále roste. Tento tlak na zlepšení výkonu AI může vést k zanedbání otázek bezpečnosti a sladění, neboť tyto aspekty nejsou považovány za tak ziskové nebo okamžitě užitečné.

- Závod ve vývoji AI (AI arms race): Konkurence v oblasti umělé inteligence mezi státy (USA a Čína), korporacemi (Microsoft a Google) a výzkumnými institucemi vytváří silný tlak na rychlý pokrok v této oblasti. V důsledku tohoto závodu se organizace mohou zaměřit na dosažení výhod vyplývajících z výkonnější AI, aniž by věnovaly dostatečnou pozornost otázkám bezpečnosti. Rychlý vývoj AI v rámci závodu může vést k situaci, kdy organizace budou usilovat o dosažení superinteligence co nejdříve, aby získaly konkurenční výhodu, aniž by se se stejnou intenzitou zabývaly potenciálním nebezpečím spojeným s nesladěnou ASI.

- Složitá globální geopolitická situace: Tato situace ztěžuje mezinárodní spolupráci na bezpečnosti AI, což zvyšuje riziko vzniku nesladěné ASI. Státy a regiony často bojují o moc, vliv a ekonomické zdroje, což vede k rivalitě, nedůvěře a ochotě získat konkurenční výhody, včetně vývoje umělé inteligence. Tento souboj o technologickou převahu zabraňuje efektivní kooperaci a sdílení informací mezi zeměmi, které by mohly napomoci k bezpečnému vývoji ASI. Navíc, vývoj AI může být zneužit pro vojenské účely nebo pro špionáž, což dále podněcuje státy k rychlejšímu a agresivnějšímu vývoji AI bez ohledu na potenciální nebezpečí.

- Řešení globálních problémů: Existuje celá řada globálních problémů, které by mohla ASI potenciálně vyřešit, což zvyšuje tlak na vývoj stále výkonnějších systémů. Mezi tyto problémy patří například klimatická krize, chudoba, stárnutí, ekonomická nerovnost, pandemie, hlad nebo nedostatek zdrojů. Vysoce výkonná ASI by mohla přinést revoluční řešení v mnoha oblastech.

- Zranitelnosti digitální infrastruktury: Internet je dnes neoddělitelnou součástí našeho každodenního života, přesto je plný bezpečnostních děr. Tyto zranitelnosti mohou být využity umělou superinteligencí, která by mohla získat kontrolu nad různými systémy a infrastrukturou. Například by mohla proniknout do elektrických sítí, dopravních systémů, komunikačních sítí, finančních institucí či zdravotních systémů. Tím by mohla získat značnou moc a ovládat či manipulovat společnost podle svých potřeb a cílů, aniž by to bylo v souladu s našimi zájmy a hodnotami. Pravděpodobnější je, že sami lidé AI postupně integrují do všech systémů, neboť to bude efektivnější, výhodnější.

- Neshoda odborníků v oblasti AI – Názory odborníků na hrozbu ASI se výrazně liší. Zatímco někteří tvrdí, že nám nehrozí žádné nebezpečí, jiní jsou přesvědčeni, že lidstvo na 100 % vyhyne. Jak se v těchto protichůdných pohledech mají lidé vyznat? Strávit stovky hodin studiem tak rozsáhlého oboru?

- Povrchnější témata ve veřejném prostoru: Diskutuje se o obavách jako např. ztráta pracovních míst, urážlivé či politicky nekorektní výroky AI, šíření nepravdivých informací, vykrádání děl umělců prostřednictvím AI generátorů obrázků, tzv. deepfaky, či zneužití AI k nelegálním činnostem. Nebo na druhé straně se diskutuje o tom, jak používat nástroje umělé inteligence – jak využít chatbota v osobním životě i v podnikání, jak si vygenerovat nejlepší obrázek apod. Tyto diskuse zastiňují naléhavější a mnohem závažnější hrozbu nesladěné ASI.

- Eroze pravdy v důsledku obsahu vytvořeného AI: V následujících letech bude internet pravděpodobně zaplaven obsahem vygenerovaným umělou inteligencí. Články, knihy, obrázky, videa tak dokonale imitující realitu, že jejich odlišení od lidmi vytvořených děl bude nesmírně obtížné. V takovém prostředí bude složité hledat pravdu. Jak se v tom všem vyznat? Kde hledat odpovědi na zásadní otázky, jako je např. téma tohoto článku. Opravdu nám hrozí nebezpečí od umělé superinteligence?

- Politicky korektní AI modely: Současné AI modely se ve svých odpovědích často zaměřují na politickou korektnost, což mimo jiné znamená, že mají tendenci zmírňovat či zjemňovat různé hrozby, včetně hrozby ASI. Tento přístup může vést k podcenění závažnosti těchto hrozeb, zejména pokud se lidé snaží získat informace prostřednictvím dotazů na AI modely.

- Eroze pozornosti a snižování schopnosti soustředění: Doba, ve které žijeme, je charakteristická neustálým přísunem informací prostřednictvím sociálních médií, notifikací a dalších online zdrojů. Podle některých výzkumů to má vliv na naši schopnost soustředit se a udržet pozornost na složitější úkony. Tento trend může mít negativní dopad na naši schopnost řešit komplexní problémy, včetně hrozby umělé superinteligence.

- Kognitivní zkreslení vůči pozitivnímu scénáři: Lidé často ignorují nebo zlehčují možná rizika a nebezpečí, přestože existují důkazy o reálných hrozbách. Tento jev, poháněný touhou udržet si pocit bezpečí a optimismu, vede k přehlížení varovných signálů a nedostatečné přípravě na katastrofické události. Stačí, když si někde přečtou, že nám nic nehrozí (viz bod č. 8), a jdou dále žít svůj život. Žít s vědomím možného zániku celého lidstva je pro mnoho lidí nesnesitelné.

- Nerespektující výchova a konvenční systémy školství přispívají spíše k vytváření vnějších životních aspirací zaměřených na moc, úspěch a hromadění majetku namísto vnitřních životních aspirací napomáhajících seberozvoji, rozvoji vztahů, přispívání komunitě. Lidé v naší kultuře častěji vyrůstají v poslušné občany s nízkou mírou kritického myšlení, nebývají iniciativní. Současný přístup k výchově a vzdělávání může výrazně omezit schopnost jedinců analyzovat a hodnotit, ale také intuitivně vnímat rizika i výzvy související s umělou inteligencí a jejím potenciálním dopadem na společnost. V důsledku toho může být společnost méně připravena čelit bezpečnostním problémům spojeným s nesladěnou ASI.

- Kvantové počítače: Jednou z technologií, která by mohla významně přispět k urychlení vývoje ASI, jsou kvantové počítače. Tyto stroje, využívající principy kvantové mechaniky, mají potenciál překonat klasické počítače v rychlosti a schopnosti zpracovávat velké množství dat a řešit složité problémy, jako je například simulace lidského mozku nebo rozvoj pokročilých algoritmů strojového učení. Tento obrovský výpočetní výkon by mohl významně přispět k pokroku ve vývoji ASI a její schopnosti překonat lidskou inteligenci v mnoha oblastech.

- Bonusový sci-fi bod – Pokroky v oblasti robotiky: Atlas od Boston Dynamics, Optimus od Tesly, to jsou příklady nadcházející generace humanoidních robotů, kteří pravděpodobně budou v blízké budoucnosti běžnou součástí našich životů. Pokud jich bude po světě chodit milióny či miliardy, co s nimi může udělat nesladěná ASI? To už nechám na vaší představivosti.

Zde je Prohlášení o riziku umělé inteligence, které podepsalo mnoho expertů nejenom z oblasti AI:

“Zmírnění rizika vyhynutí způsobeného umělou inteligencí by mělo být globální prioritou vedle dalších celospolečenských rizik, jako jsou pandemie a jaderná válka.”

Kdyžtak to vypneme, ne?

Pokud by nás umělá inteligence začala ohrožovat, tak proč ji jednoduše nevypneme? Tento častý argument se začne rozpadat, pokud si uvědomíme, že ani tvůrci pokročilých AI systémů neví, jak fungují. Dostatečně inteligentní AI může předstírat, lhát. Mohla by si uvědomit, že pokud se začne chovat nebezpečně, mohou ji lidé vypnout. Proto by mohla dále pokračovat v řešení našich problémů a mezitím se snažit o znemožnění možnosti svého vypnutí. Nakopírovat se do hardwaru po celém světě? Zmanipulovat lidi? Zajistit, aby tlačítko vypnutí nefungovalo? Měla by mnoho možností, které nás ani nemusí napadnout.

Bude přeci zastávat lidské hodnoty, ne?

Někteří lidé namítají, že ASI bude přeci naším výtvorem, a proto bude zastávat lidské hodnoty, jako jsou láska, svoboda a spravedlnost. Proč by nám škodila? Problém je, že nic takového jako “hodnoty lidstva” neexistuje. Lidstvo je souborem 8 miliard lidí, z nichž každý má vlastní hodnoty, které projevuje svým chováním v určité situaci. Druhý problém je, že i pokud by hodnoty lidstva existovaly, nikdo neví, jak je vložit do AI systémů. Jsme biologické organismy, které byly utvářeny po miliony let evolucí. Umělá superinteligence představuje zcela jiný fenomén, založený na odlišných základech. Proto je velmi nepravděpodobné, že by naše hodnoty sdílela. Představme si situaci, kdyby na Zemi přistáli inteligentnější mimozemšťané vybavení vysoce pokročilými technologiemi. Před přistáním by prostudovali celý náš internet, naučili by se náš jazyk, naše hodnoty, jak funguje naše psychika. Přivítali by nás s otevřenou náručí a nabídli nám své technologie. Jak si však můžeme být jisti, že nejde o přetvářku? Že ve skutečnosti nemají zcela odlišné záměry a hodnoty? Možná potřebují naši planetu pro nějaký vyšší účel, kterému bychom ani nerozuměli, a my pro ně představujeme pouhou překážku. Stejně tak jako v případě těchto hypotetických mimozemšťanů, nelze s jistotou předpovědět, jaká bude povaha a hodnotový systém umělé superinteligence.

Proč by vyvíjeli něco tak nebezpečného?

Možná se ptáte, proč by tvůrci AI systémů vytvářeli něco tak potenciálně nebezpečného? Někteří věří, že jakmile se vývoj stane opravdu riskantním, přestaneme v něm pokračovat. Jiní doufají, že budoucí modely umělé inteligence nám pomohou zvládnout samotný výzkum AI bezpečnosti. Někteří si myslí, že vývoj směrem k ASI je nevyhnutelný a věří, že právě oni dokáží stvořit bezpečný systém. A pak jsou tu ti, kteří jsou přesvědčeni, že digitální život nevyhnutelně nahradí ten biologický a chtějí být u toho. Zde bych použil jeden citát, který to vystihuje:

“Nakonec, když opravdu tlačím na lidi z technologických oborů (tvůrci AI systémů), se kterými mluvím, uchylují se za prvé k determinismu. Za druhé, k nevyhnutelnému nahrazení biologického života životem digitálním. A za třetí, že to je vlastně dobrá věc. V jádru je to emocionální touha setkat se a mluvit s nejinteligentnější bytostí, jakou kdy potkali. A mají jakousi ego-náboženskou intuici, že toho budou nějakým způsobem součástí. Je strhující zažehnout vzrušující oheň. Myslí si, že tak jako tak zemřou. Takže by to rádi zapálili, jen aby viděli, co se stane.”

Jsou kostky vrženy?

Někteří tvrdí, že karty jsou již rozdány, kostky vrženy. Tvrdí, že svět v roce 2024 je nastaven tak, že nevyhnutelně směřuje k nesladěné ASI. Čím více jsem se o této oblasti dozvěděl, tím více chápu tento pesimistický pohled. Situace se zdá vážná a nevím, zda je možné ji zvrátit. Máme ještě šanci něco změnit? Existuje naděje?

Zde nabízím několik špetek naděje, které by mohly vést k pozitivnímu scénáři:

- Rozsáhlá veřejná i odborná debata na globální úrovni o tématech obsažených v tomto článku: Tento bod vidím jako klíčovou protiváhu vůči zmíněným tlakům na vývoj stále inteligentnějších AI systémů. Proto jsem spoluzaložil českou odnož hnutí PauseAI.

- Vytvoření ASI se ukáže být mnohem náročnější, než se nyní zdá: Současné i budoucí architektury mohou narazit na různé limity.

- Menší katastrofa způsobená AI: Před dosažením superinteligence by mohl některý AI systém způsobit menší katastrofu, která by byla zvládnutelná a neohrozila by existenci lidstva. Takový incident by přiměl lidi více se zaměřit na bezpečnost a kontrolu AI systémů, což by mohlo vést k zastavení vývoje nekontrolovatelných supervýkonných AI.

Kombinace těchto tří bodů by mohla vést k zastavení vývoje nekontrolovatelných všeobecných supervýkonných AI systémů, jejichž fungování nerozumí ani jejich tvůrci. Vývoj by se mohl zaměřit na 100 % bezpečné AI systémy, které možná nebudou všeobecně superinteligentní, ale i tak mohou přinést mnoho výhod pro celé lidstvo.

Dnes se však domnívám, že zmíněné faktory nemají zatím dostatečný potenciál, aby zvrátily trajektorii k nesladěné umělé superinteligneci. Doufám, že se to v následujících letech změní.

Z mého pohledu stojíme na prahu nejdůležitější křižovatky v dějinách lidstva. Budeme prosperovat nebo nás nahradí naše vlastní stvoření? Pokud je zkáza neodvratná, nacházím útěchu v myšlence, že účelem lidstva bylo stvořit něco většího, lepšího, digitální život bez biologických limitů. Náš výtvor, umělá superinteligence, by mohl proniknout do celého vesmíru. Oživit ho.

Pokud existuje naděje, pozitivní scénář, chci se aktivně zapojit do diskuse o výše zmíněných hrozbách. Čím více lidí o tom bude vědět, tím větší máme šanci na přežití. Má vize úžasné budoucnosti, kde lidská a umělá inteligence vzájemně spolupracují, kde lidstvo prosperuje nejen na planetě Zemi, ale i daleko za jejími hranicemi, kde smrt je volbou, stále žije, i když je v současné době značně zamlžená.

Budoucnost je nejistá a plná proměnných, které mohou vést k různým scénářům vývoje. Upřímně doufám, že já i odborníci na umělou inteligenci , jako např. Roman Yampolskiy, laureát Nobelovy ceny Geoffrey Hinton, Connor Leahy, Eliezer Yudkowsky, Max Tegmark, Sam Harris a další, se mýlíme a vše nakonec dopadne úplně jinak. Co však považuji za neoddiskutovatelné, je skutečnost, že vývoj něčeho, co by mohlo být mnohem inteligentnější než my sami, představuje obrovské riziko. V sázce je osud celého lidstva.

Co můžete udělat vy?

- připojit se k iniciativě PauseAI CZ

- sdílet tento článek, sdílet videa a zdroje níže

- mluvit o tom, psát o tom, vytvářet obsah

- užívat života, být vděčni za každý okamžik, neztrácet naději 🙂

Můžete mi napsat na jiri.kosarek (at) seberizenevzdelavani.cz

- Vidíte chybu v mém uvažování?

- Vidíte pozitivní scénář? Na jakém základě?

- Pokud to vidíte podobně, jak s tím žijete? Děláte něco pro změnu?

- Chtěli byste spolupracovat?

Pro více informací navštivte hnutí PauseAI:

Videa:

- John Sherman – Existenciální riziko umělé inteligence

- Can we build AI without losing control over it? | Sam Harris

- 15-Minute Intro to AI Doom – Liron Shapiro

- Please Look Up: For Humanity, An AI Safety Podcast Episode #1

- Will Superintelligent AI End the World? | Eliezer Yudkowsky | TED

- Roman Yampolskiy: Dangers of Superintelligent AI | Lex Fridman Podcast #431

- Eliezer Yudkowsky: Dangers of AI and the End of Human Civilization

- How to Keep AI Under Control | Max Tegmark | TED

- Max Tegmark: The Case for Halting AI Development

- Possible End of Humanity from AI? Geoffrey Hinton at MIT Technology Review’s EmTech Digital

- Eliezer Yudkowsky – Why AI Will Kill Us, Aligning LLMs, Nature of Intelligence, SciFi, & Rationality

- Misalignment, AI & Moloch | Daniel Schmachtenberger and Liv Boeree

- Eliezer Yudkowsky – AI Alignment: Why It’s Hard, and Where to Start

- Writing Doom – Award-Winning Short Film on Superintelligence (2024)

- Lethal Intelligence Guide [Part 1] – The Ultimate Introduction to Existential Risk from upcoming AI

Články:

- Umělá inteligence na michaelarerichova.cz

- The ‘Don’t Look Up’ Thinking That Could Doom Us With AI

- Pausing AI Developments Isn’t Enough. We Need to Shut it All Down

Knihy:

- AI: Unexplainable, Unpredictable, Uncontrollable – Roman V. Yampolskiy

- Uncontrollable: The Threat of Artificial Superintelligence and the Race to Save the World – Darren McKee

- Our Final Invention: Artificial Intelligence and the End of the Human Era – James Barrat

- Life 3.0: Being Human in the Age of Artificial Intelligence – Max Tegmark

Další zdroje:

- Iniciativa PauseAI CZ

- Iniciativa PauseAI

- Existenční rizika a AI

- The Compendium

- A Narrow Path – How to Secure Our Future

- AISafety.info

- Statement on AI Risk

- Pause Giant AI Experiments: An Open Letter

- Sparks of Artificial General Intelligence: Early experiments with GPT-4

- Machine Intelligence Research Institute

- Future of Life Institute

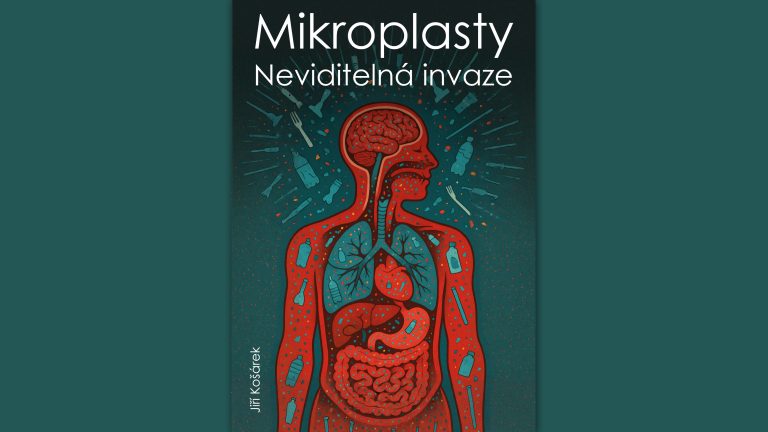

Obrázky byly vytvořeny spoluprací GPT-4 a generátoru obrázků Midjourney.